一、前言

TacoAI,全称为 Topsfuture AI Computing Optimized,是一个专为边缘计算场景打造的高性能、全栈式 AI 应用开发平台。我们的目标是提供一套从模型开发、代码编译到设备端部署运行的端到端优化解决方案,帮助开发者高效地构建并落地各类边缘 AI 应用。

1.1 概述

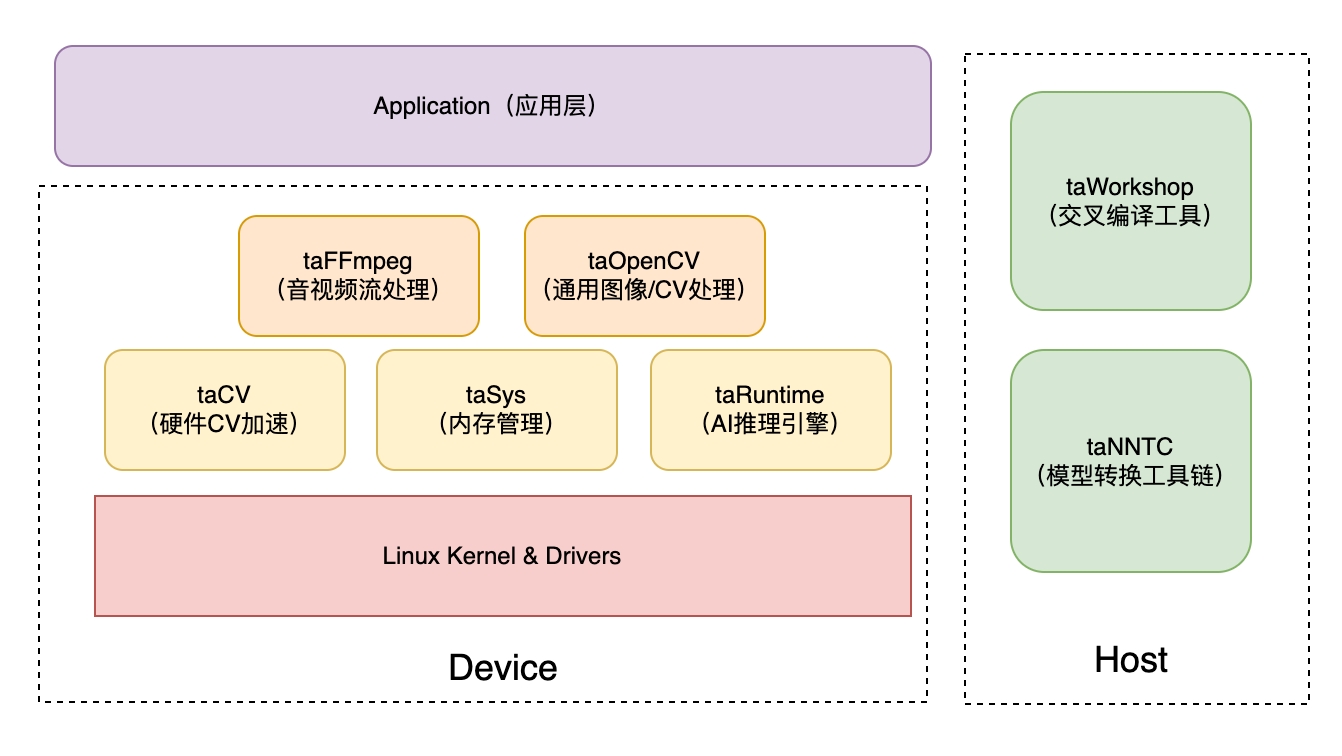

TacoAI 的生态系统在设计上清晰地划分为两个主要部分:Host(开发端) 和 Device(设备端)。

Host(开发端):

- 运行在开发者 PC 或服务器上,基于 Docker 环境

- 提供完整的开发与编译工具链,包括:

- taWorkshop:用于交叉编译应用程序

- taNNTC:用于 AI 模型转换优化

- 所有开发阶段的工作均在此完成

Device(设备端):

- 指最终部署应用的 TacoAI 硬件平台

- 搭载经过深度优化的 AI Stack 软件栈

- 负责高效运行应用程序和 AI 模型

这种"开发与运行分离"的模式,确保了开发者可以在熟悉的 x86 环境下进行高效开发,同时保证了应用在目标设备上运行时能获得最佳的性能和兼容性。

1.2 框架架构(AI Stack)

TacoAI 的核心竞争力在于其设备端的 AI Stack 软件栈。该软件栈采用分层设计,实现了从底层硬件驱动到上层应用接口的全面优化,确保每一层都能高效协同工作。

1. 应用层

这一层是开发的具体业务应用,例如:

- 智能安防

- 质量检测

- 智慧零售

应用代码会调用下层框架提供的 API 来实现所需功能。

2. 框架层

该层面向快速应用开发,提供了一系列与开源社区标准兼容的高级 API,封装了复杂的底层实现,是开发者最常直接交互的层次。

主要组件包括:

- taFFmpeg:硬件加速的多媒体框架,用于高效处理音视频的编解码和推拉流任务

- taOpenCV:经过 RISC-V Vector(RVV)硬件加速的计算机视觉库,提供了丰富的通用图像处理算法接口

3. 中间件层

这是 TacoAI 平台的核心,负责连接上层应用与底层硬件,提供核心功能引擎和硬件抽象。

核心组件包括:

- taRuntime:AI 推理引擎,负责加载、管理并高效执行 AI 模型,是整个 AI Stack 的核心

- taCV:硬件 CV 加速库,提供对专用图像处理单元(SPP)的直接访问接口,用于极致性能的图像预处理

- taSys:内存管理核心,是平台高性能的基石。它负责管理硬件单元所需的特殊内存,是实现"零拷贝"数据流转的关键

4. 内核层

该层是整个软件栈的基础,由以下组件组成:

- Linux 内核

- 硬件驱动程序

负责最基础的资源管理和对硬件的直接控制。

通过这套分层架构,TacoAI 实现了灵活性与高性能的统一。开发者既可以利用框架层快速构建应用,也可以在性能瓶颈点深入中间件层进行精细优化,从而满足不同场景下的开发需求。